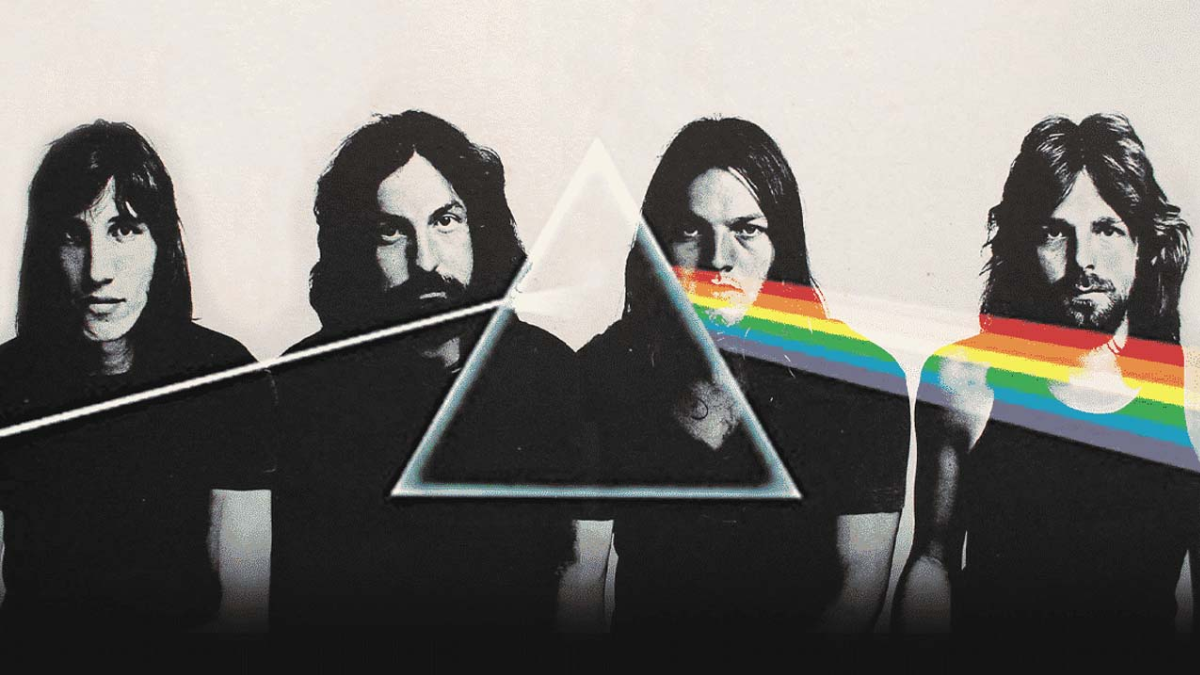

Muchas bandas icónicas dentro del rock han dejado una huella imborrable, sonidos como los creados por The Beatles son difíciles de igualar aun con la tecnología disponible, la fuerza de The Rolling Stones es fascinante sin importar la época en que se escuche, la originalidad del sonido de una agrupación como The Doors es difícil de explicar, y muchas más bandas que han puesto su grano de arena en la historia de la música. Existe otra agrupación que ha desafiado hasta la misma ciencia para su entendimiento, por ello la neurociencia pone énfasis en los sonidos de Pink Floyd.

Se ha dado a conocer que un grupo de neurocientíficos reconstruyeron una canción de Pink Floyd escuchando ondas cerebrales de oyentes. Se dice que es la primera vez que los científicos reconstruyen una canción a partir de las grabaciones de la actividad cerebral.

LA IA RECONSTRUYE “ANOTHER BRICK IN THE WALL” CON UN GRAN DESCUBRIMIENTO A FAVOR DE LOS TRASTORNOS NEUROLÓGICOS

La pieza elegida para esta investigación no podía ser otra que “Another Brick in the Wall”, analizada a partir del análisis de las ondas cerebrales de pacientes sometidos a cirugías de epilepsia mientras escuchaban la canción original de 1979.

Esta innovadora hazaña marca la primera vez en la que se ha decodificado una melodía reconocible a partir de registros de actividad eléctrica cerebral.

Además, estos resultados prometen arrojar datos sobre la manera en que percibimos el sonido teniendo implicaciones valiosas para la mejora de dispositivos destinados a personas con trastornos neurológicos que afectan el habla, como el ictus o la esclerosis lateral amiotrófica (ELA), la misma enfermedad que afectó al científico Stephen Hawking.

Para alcanzar este hito científico, Robert Knight y su equipo en la Universidad de California en Berkeley estudiaron las grabaciones de electrodos implantados en el cerebro de 29 personas como parte de tratamientos para la epilepsia. Con un total de 2.668 electrodos para registrar la actividad cerebral, se identificaron 347 de ellos como relevantes para la música en cuestión.

LAS SEÑALES CEREBRALES PUEDEN TRADUCIRSE EN RITMO Y ENTONACIÓN

FOTO: X @PLOSBiology

En este estudio se compararon las señales cerebrales con la canción original, según el comunicado de prensa, los investigadores identificaron un subconjunto de electrodos particularmente vinculado al tono, la melodía, la armonía y el ritmo. Específicamente, encontraron una región en el complejo auditivo del cerebro conocida como la circunvolución temporal superior (STG en inglés), que parece representar el ritmo, en este caso, el ritmo de la guitarra.

Finalmente, la IA, una vez entrenada, pudo reproducir un fragmento no visto de la canción basándose en las señales cerebrales de los participantes.

Según New Scientist, el espectrograma, es decir una visualización de las ondas de audio del clip generado por la IA era un 43 % similar al clip de la canción real.

Los registros de la investigación publicados en la revista PLOS Biology, demuestran entonces que las señales cerebrales pueden traducirse en los elementos musicales del habla, como ritmo y entonación, que aportan significado que las palabras que por sí solas no pueden expresar.

Aunque ya existen tecnologías para decodificar palabras en personas que no pueden hablar, los investigadores señalan que las frases generadas hasta ahora suenan de manera robótica. Este avance podría allanar el camino hacia dispositivos protésicos más avanzados, que mejoren la percepción del ritmo y la melodía en el habla. https://youtu.be/TjrfuDAEl10